LM Studio: 跨平台本地运行开源大模型

见字如面,与大家分享实践中的经验与思考。

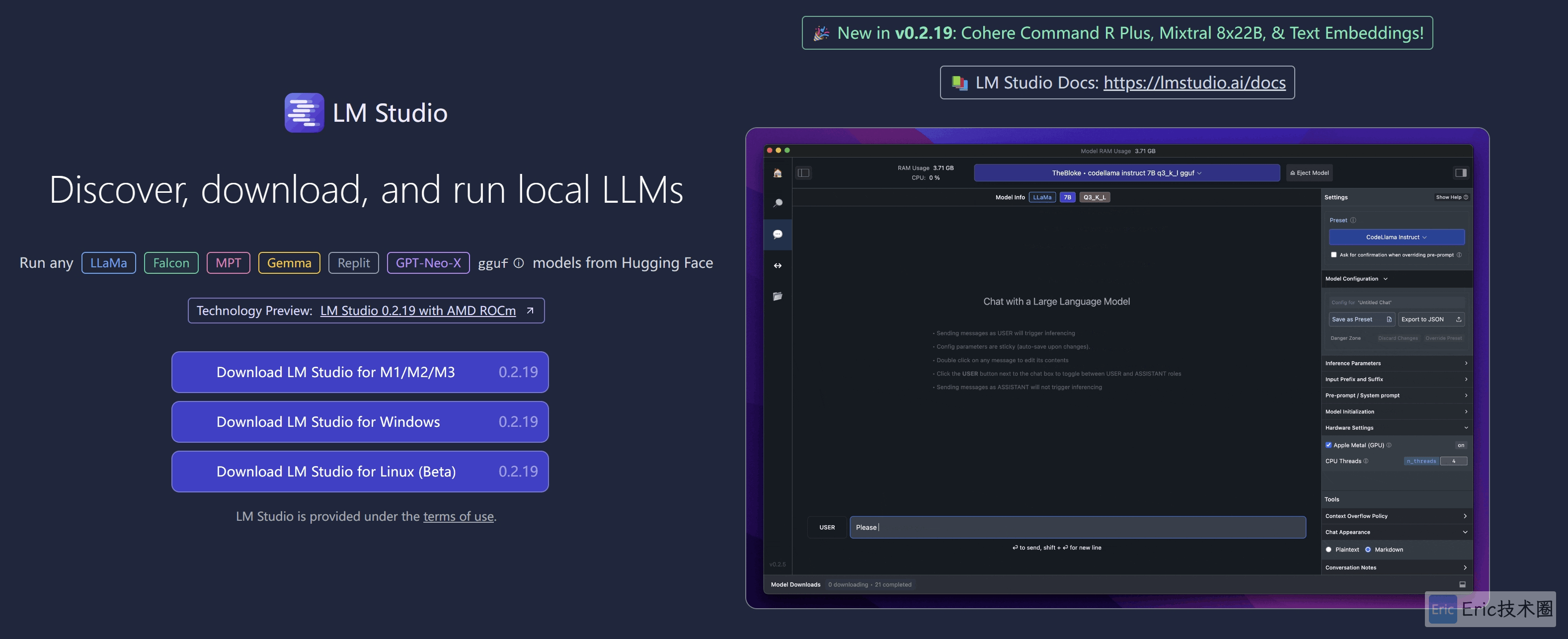

LM Studio官网

因为我的MacBook CPU是Intel而不是M系列的,所以我使用Windows台式机进行测试。

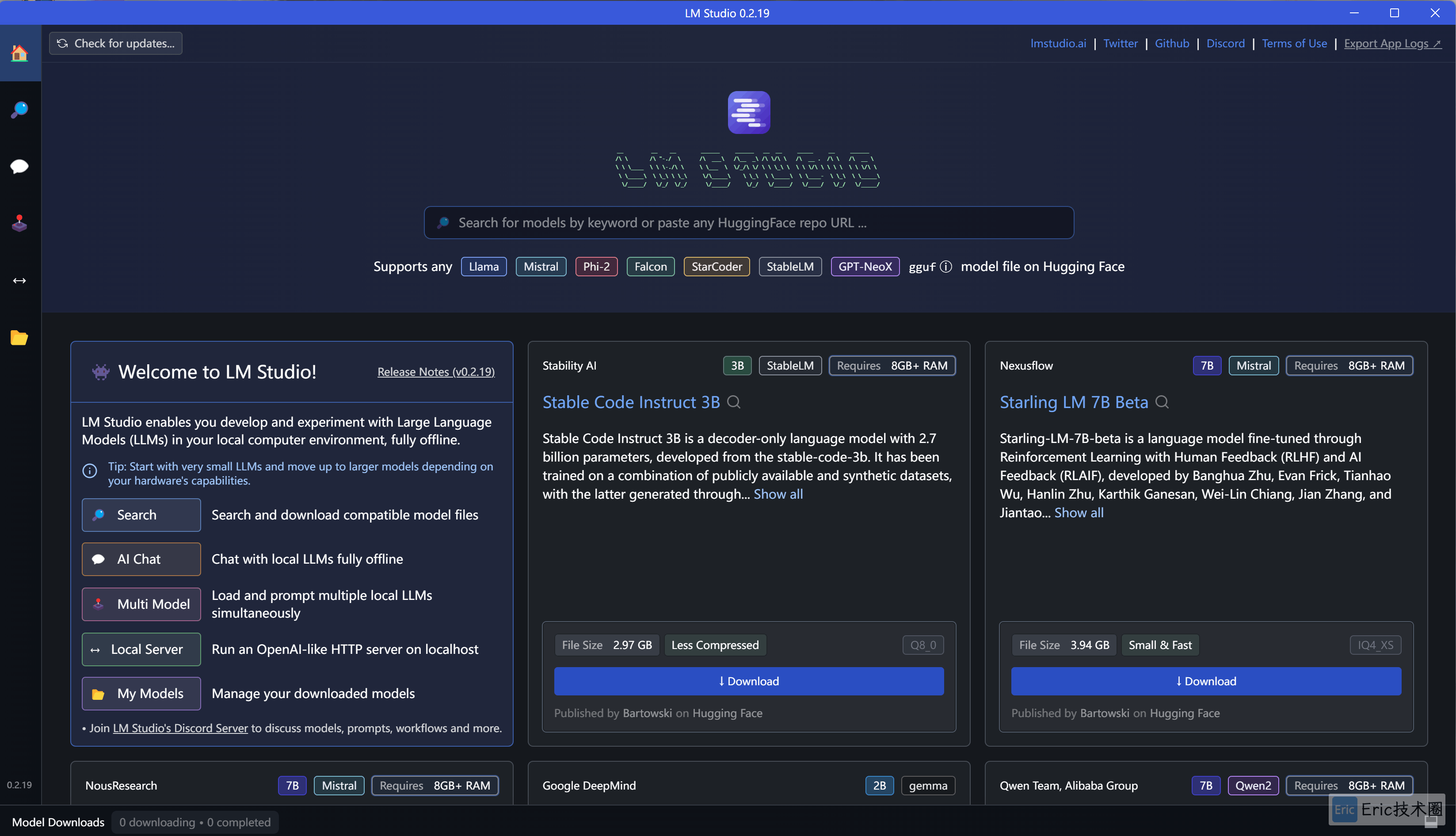

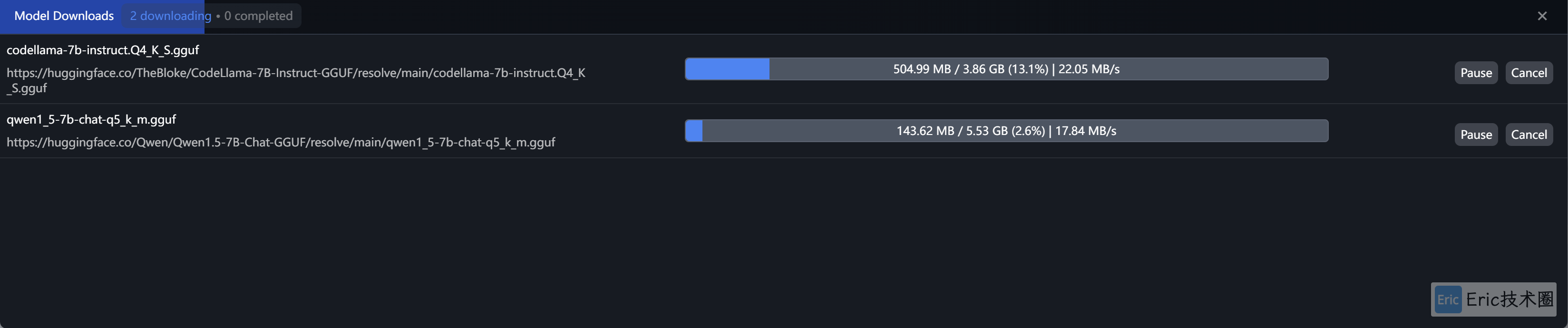

模型下载

因为它的模型都来源于 Hugging Face,需要科学上网才能下载模型。

下载几个模型试下:

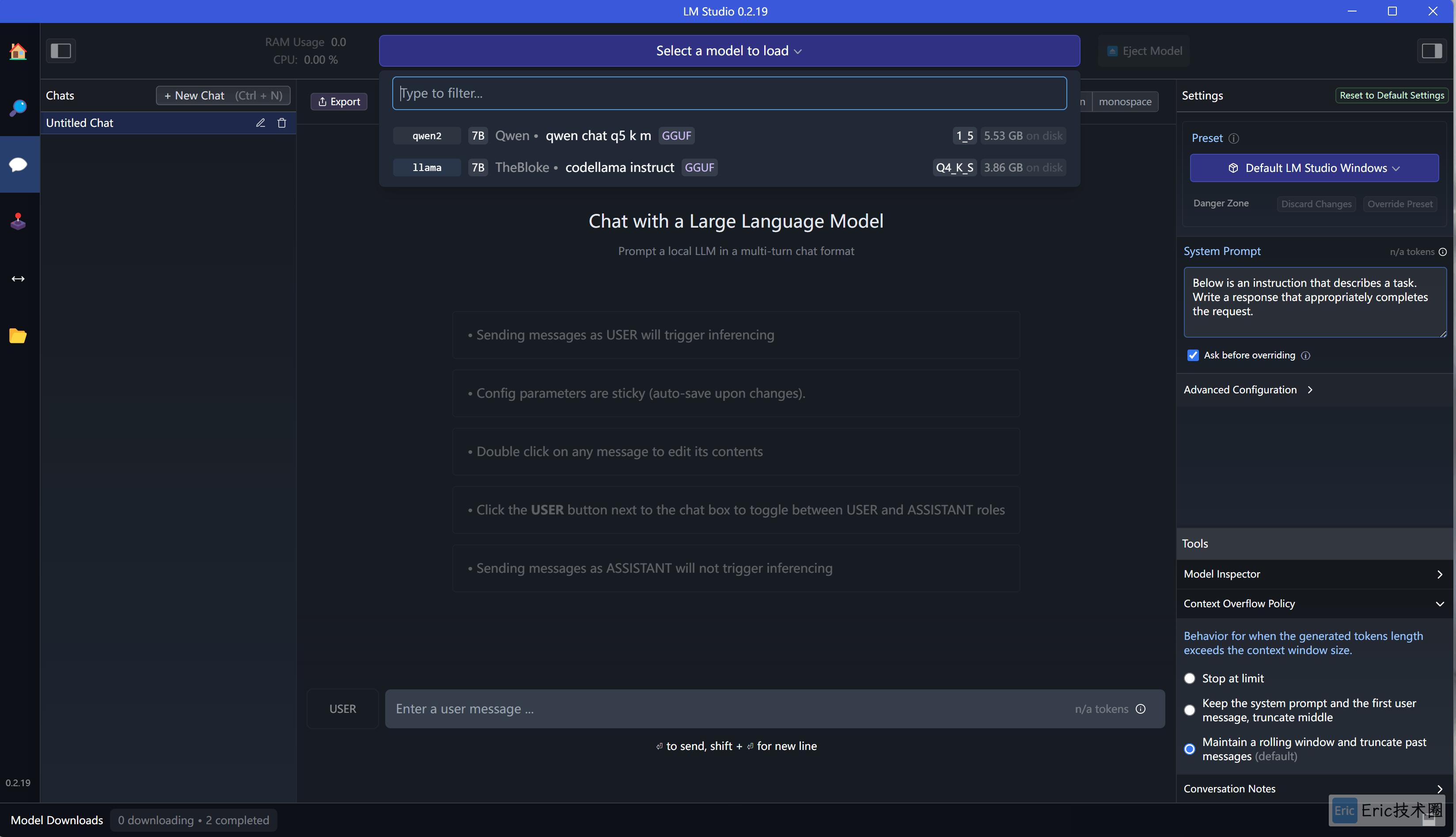

运行使用

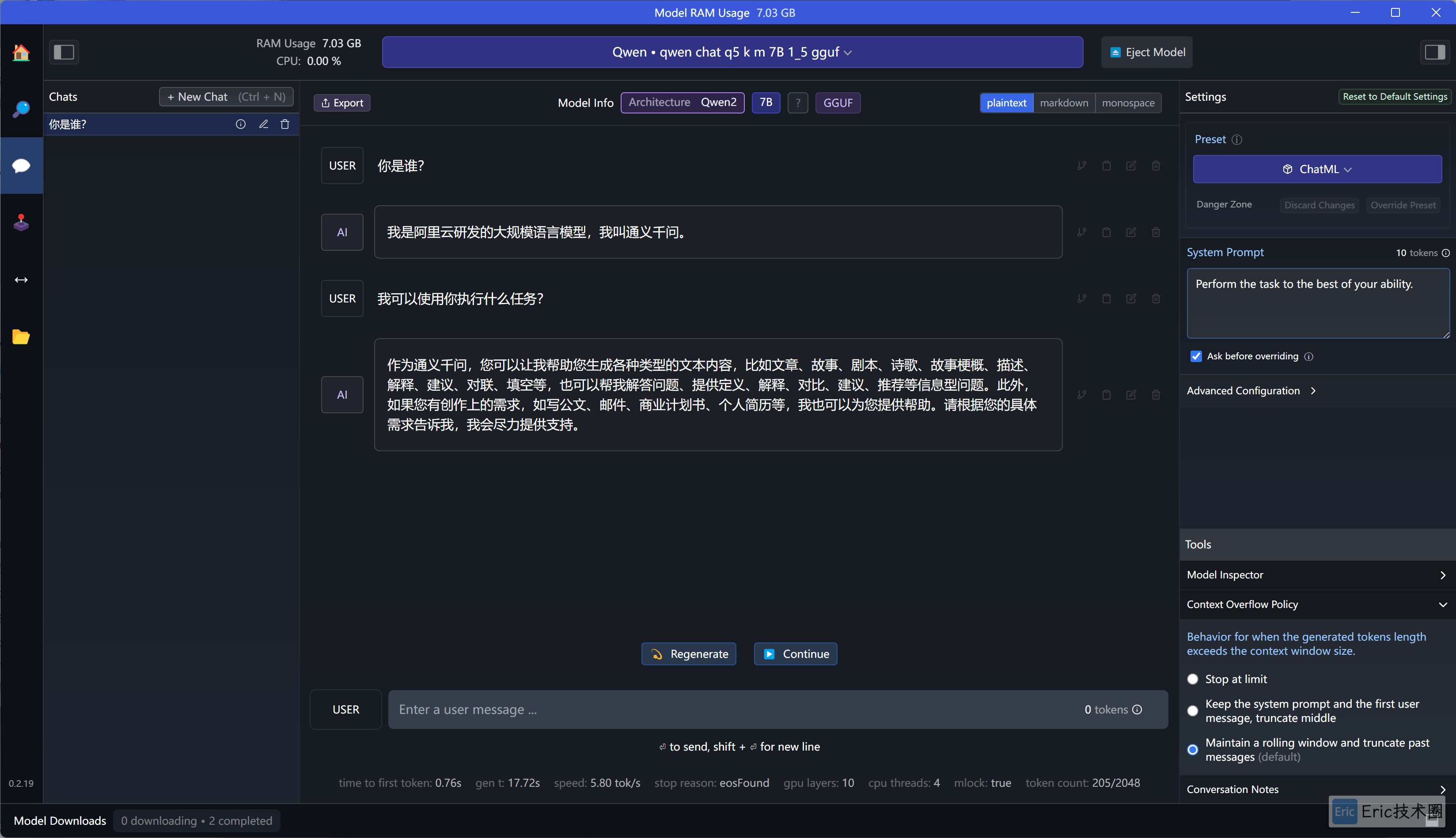

点击AI Chat,然后选择不同的模型,进行chat聊天。

使用过程非常流畅,比我的MacBook本地使用Ollama搭建的,快了很多,几乎没有感受到什么延迟。而且右侧又很多内置的Prompt,也可以按照自己的需求进行调整。

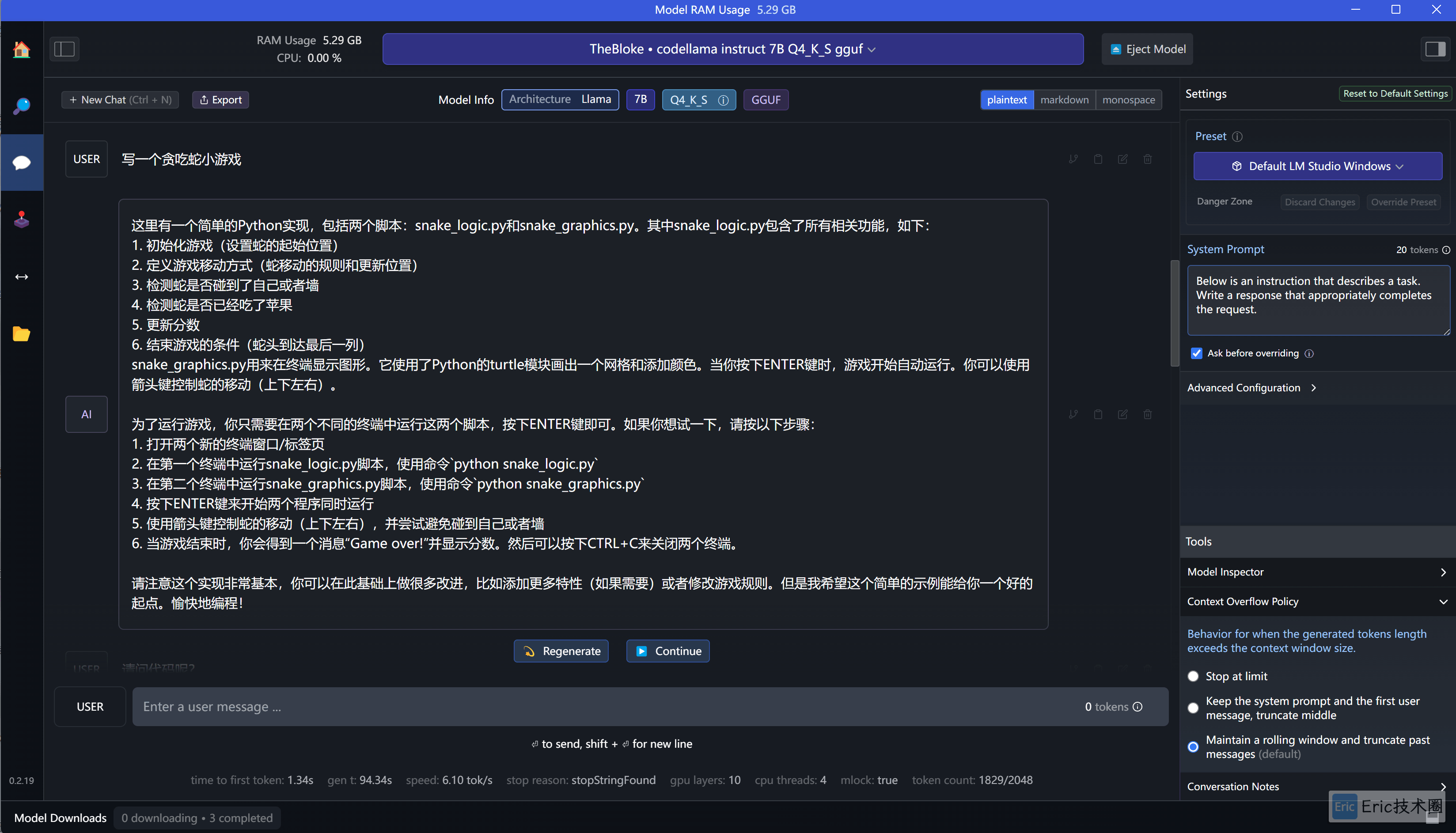

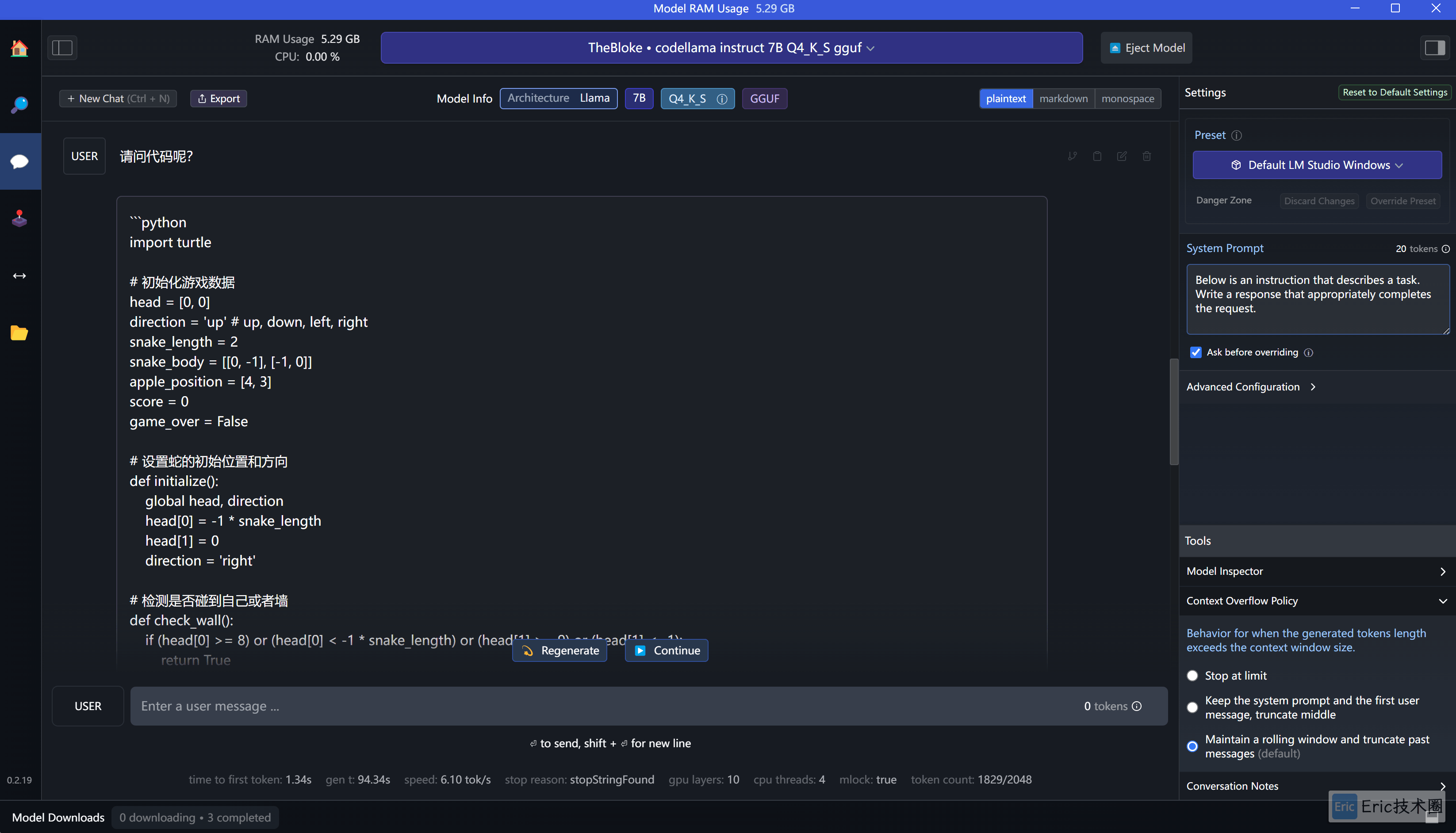

切换到 codellama 模型让它帮我写一个贪吃蛇游戏:

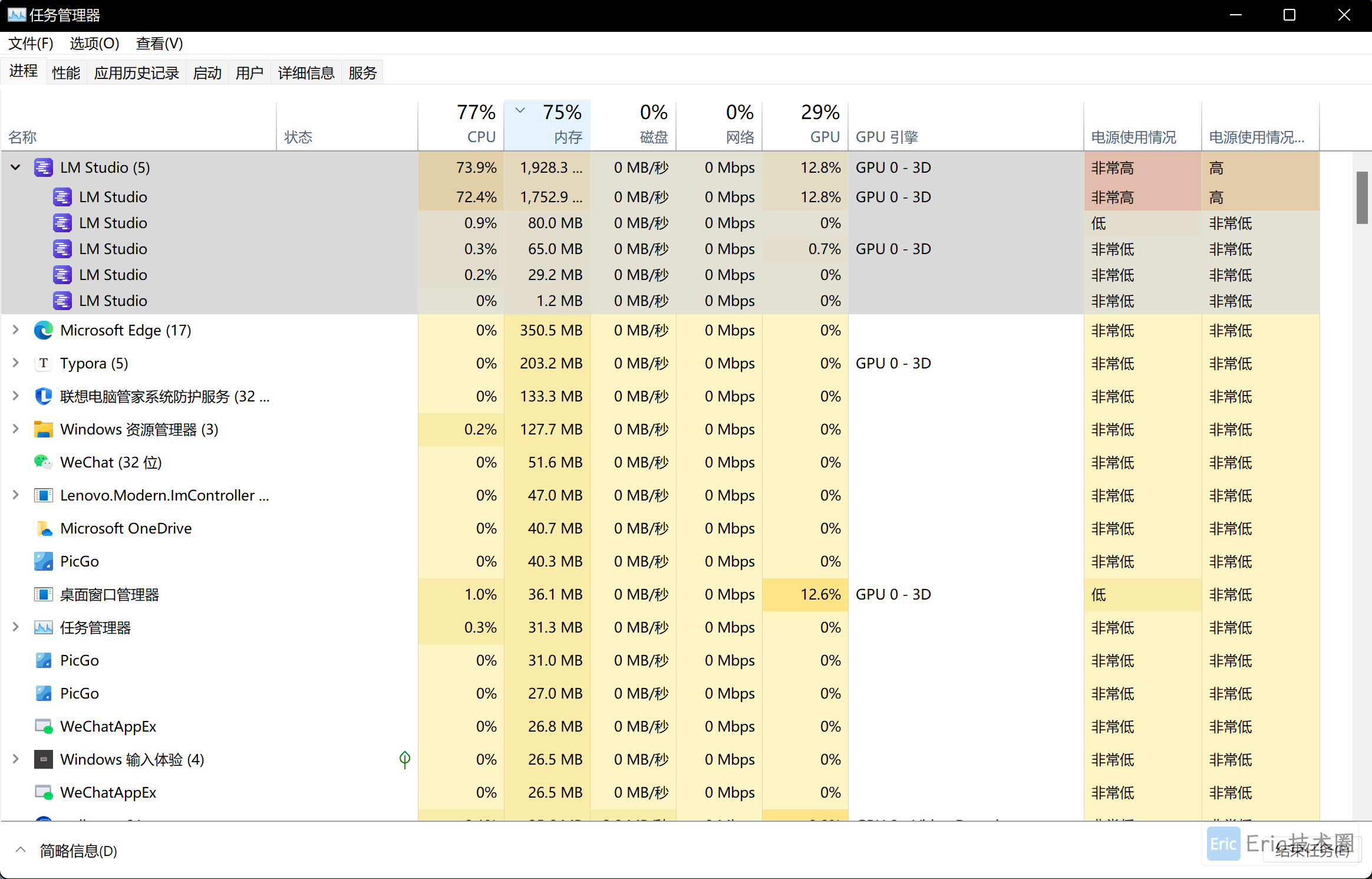

下面是资源的占用情况,CPU和RAM还是比较高的,GPU占用较低:

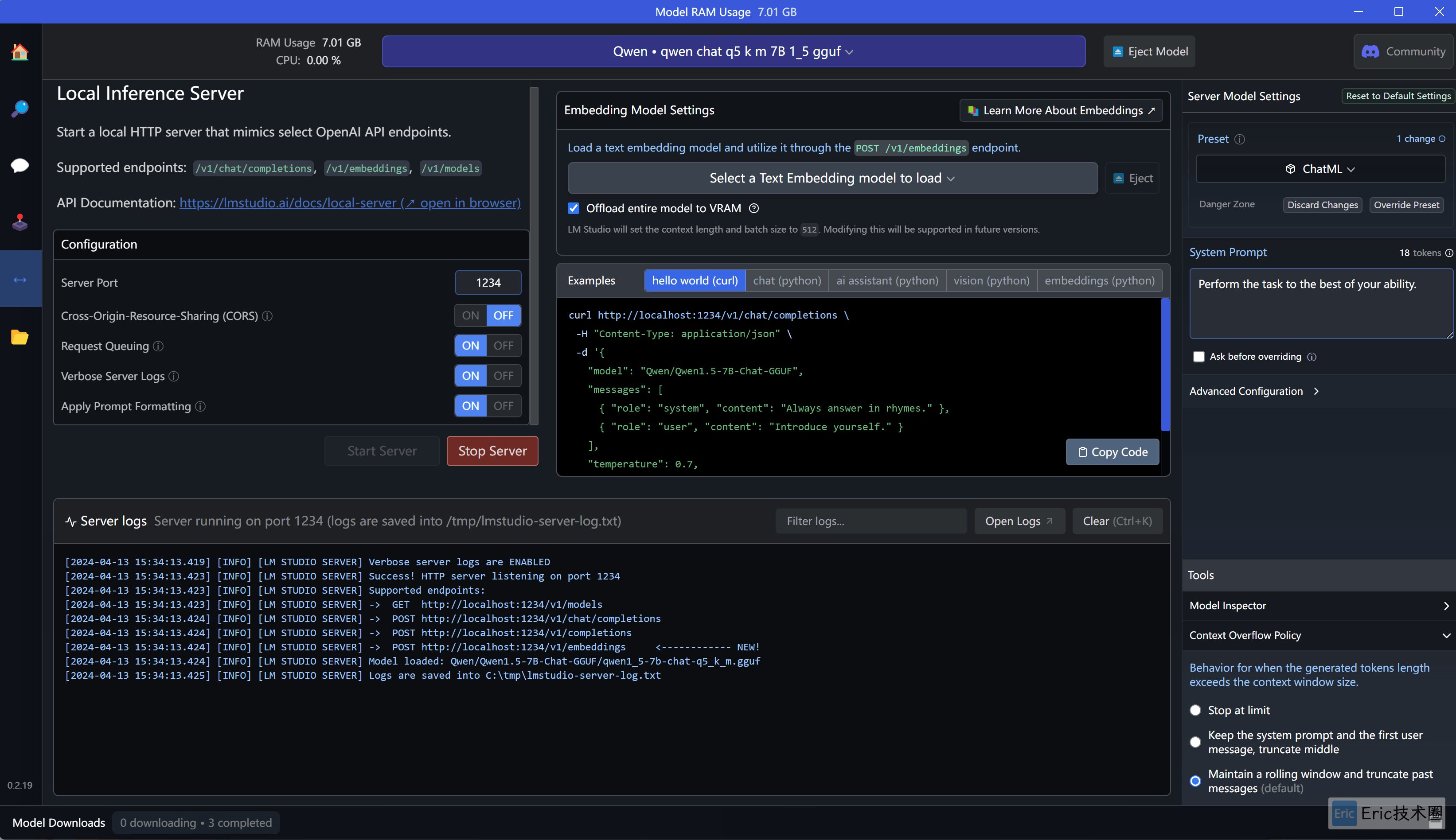

启动本地服务

采用的是类OpenAI的接口规范,同时提供了各种Examples Code,可以一键copy进行本地快速调用。

LM Studio还有一个使用 Multi Model 模式,通过加载多个模型来一起工作,因本地RAM限制这里就不做尝试了。

总结

LM Studio 初步体验下来非常的不错,它有如下优点:

可以跨平台进行安装,界面清爽,简单易用

只需要安装应用程序即可使用,不需要本地按照各种package或者语言环境

响应速度非常快,使用起来很流畅,并且可以依据电脑配置推荐合适大小的开源模型,这个真的加分(也许是 Windows的配置比MacBook好?)

模型非常多,几乎可以使用

Hugging Face中的任何模型

但是也有不可忽视的一些缺点:

在国内需要科学上网才能使用,这个对于部分人来说确实不大友好

只能下载

Huggging Face Hub中的模型,如果能够接入国产的模型Hub的话,就可以不用科学上网了并没有其他高级功能,如:传入PDF、Markdown、TXT、Video等来搭建知识库的能力,体验下来只有Chat能力,那么免费的ChatGPT 3.5不香么?

比较适合于初级体验者,能够快速本地体验开源大语言模型,对于进阶学习者如果只是chat功能,使用python脚本也能快速实现,也无法做一些高阶定制化功能

总的来说,值得关注一下和使用,简单无脑,还要啥自行车。